La reconnaissance automatique des émotions est le processus d'identification des émotions humaines par des techniques numériques. Ces outils sont issus d'un domaine encore émergent de la recherche, qui a beaucoup progressé dans les années 2020. Ils permettent d'identifier des émotions à partir d'une image, d'une vidéo, de la voix ou d'un texte (ou de manière multimodale à partir de plusieurs de ces voies, avec alors de meilleurs résultats).

GPT-4o, qui a commencé à être déployé par OpenAI en mai 2024, est la première intelligence artificielle publiquement disponible à en être nativement capable.

Les individus humains varient considérablement dans leur capacité à reconnaître leurs émotions et celles des autres. La reconnaissance des signes d'émotions sur le visage et le corps (langage non verbal), peut aider des aveugles ou personnes malvoyantes à interpréter les émotions d'interlocuteurs. Elle peut aider des personnes concernées par un trouble du spectre autistique (TSA) à exprimer ce qu'elle ressentent, et à mieux comprendre ce qu'une autre personne ressent. Matthew D. Lieberman et al., en 2007, ont montré grâce à l'IRM, que le simple fait de nommer l'émotion diminue l'activation physiologique associée dans l'amygdale et le système limbique, au profit d'une activation du cortex préfrontal ventrolatéral droit.

Cette reconnaissance automatique des émotions transmises par le visage, la voix et les mouvements et postures est cruciale pour améliorer les interactions et collaborations homme-machine, car pouvant permettre à des robots, des machines, des véhicules et à divers logiciels (y compris de jeux vidéo) d'interpréter les expressions faciales pour enclencher des rétroactions plus adaptées, « intelligentes » et empathiques.

L'outil est en soi neutre, mais il est puissant et peut avoir des usages malveillants ou sociétalement dangereux :

- il peut servir le bien commun, par exemple pour un « diagnostic en ligne » ou en télémédecine notamment pour l'évaluation de la douleur et de la santé mentale (schizophrénie par exemple), dépression, maladie de Parkinson, somnolence, fatigue, fatigue chronique, TDAH, trouble panique, ou pour mieux comprendre un bébé, un malade ou une personne âgée qui ne seraient pas en état de parler, ou pour mieux veiller à distance sur des patients présents dans un centre de soins connecté ; pour savoir si des élèves ou étudiants ou des personnes apprenant en ligne comprennent ce qu'ils lisent ou entendent, pour permettre à une intelligence artificielle de détecter des indices d'alcoolémie et/ou des signes d'inattention ou d'endormissement d'un conducteur ou d'un travailleur et ainsi diminuer le risque d'accident. Il peut aussi intéresser les autorités chargées de la sécurité ;

- il peut être utilisé pour des sondages ou études de marché ;

- il peut aussi être utilisé de manière malveillante : il peut en effet intrusivement, illégalement, et secrètement, révéler des aspects intimes et secrets de la personnalité des internautes ou de toute personne filmée dans une entreprise ou dans l'espace public (ou privé). Ceci peut avoir de graves conséquences dans un système judiciaire (car l'intelligence artificielle peut se tromper notamment parce qu'elle a surtout été formée avec les émotions de personnes adultes, blanches et plutôt masculines, et non ou peu avec des aveugles, autistes ou personnes paralysées ou victimes d'un AVC ou d'un handicap faisant que leur visage, leur voix et leur gestuelle exprime aucune émotion ou les exprime très différemment), dans le contexte d'une société et économie de la surveillance et/ou dans un régime autoritaire ou dictatorial. En complément des outils numérique d'analyses dans le Web de l'opinion publique et individuelle (opinion mining), il peut faciliter les techniques de manipulation psychologique d'internautes, d'acheteurs ou d'électeurs, notamment via les réseaux sociaux comme on l'a vu dès le milieu des années 2010 avec le scandale Facebook-Cambridge Analytica/AggregateIQ qui grâce à une intelligence artificielle baptisée RIPON a pu conduire à l'élection de Donald Trump, au Brexit et à d'autres fraudes ou manipulations électorales.

Historique

Certaines machines tendent à être conçues pour de plus en plus se comporter comme des humains pour diverses applications. Cette tendance a encouragé la création d'outils de reconnaissance automatisée des émotions humaines.

Ce domaine a émergé avec les logiciels de reconnaissance faciale qui a évolué vers l'automatisation de la reconnaissance des expressions faciales, à partir d'images et de vidéos, mais aussi à partir des expressions parlées (audio), écrites, et parfois à partir de la physiologie (pouls, électrocardiogramme, électroencéphalogramme (EEG),,, de peau (mesurées par la réponse galvanique de la peau), tremblements, couleur et aspect de la peau, mouvements des sourcils, des yeux, des narines, des oreilles, de la bouche, et diamètre de la pupille, humectation de la bouche, microréactions musculaires réflexes, etc.).

L'intelligence artificielle peut aussi contribuer à l'évaluation en temps réel de la charge mentale pesant sur un individu. Dans le domaine de la kinésique, on sait que les postures et mouvements corporels transmettent des informations spécifiques aux émotions. On a récemment proposé et testé un système de coussin intelligent qui, associé à des capteurs inertiels sur les poignets, mesure via l'analyse des postures et gestes de la personne son état émotionnel. Il pourrait par exemple aider au diagnostic d'employés de bureau, navetteurs, conducteurs longue distance ou personnes à mobilité réduite.

Quelques rappels sur les émotions

Selon sa personnalité et selon le contexte, chaque humain est plus ou moins introverti ou extraverti pour ce qui concerne ses émotions et ses intentions (plus ou moins guidées par ses émotions).

L'émotion peut être définie comme l'état psycho-physiologique et psychologique d'un être humain à un instant donné.

Les humains présentent en outre une grande variabilité dans leurs capacités à reconnaître, en eux et/ou chez les autres les émotions primaires telles que le bonheur, la peur, la colère, la surprise, la tristesse ou le dégoût et d'autres émotions secondaires plus complexes ; de même pour l'intensité et la valence (émotion positive ou négative) de l'expression émotionnelle, autant de paramètres que l'intelligence artificielle peut analyser.

La capacité humaine à reconnaitre ses propres émotions et celles d'autrui varie en outre avec l'âge, l'attention et la qualité de la vue, de l'audition et du système perceptif.

Un défaut inné (ou acquis, par exemple à la suite d'un traumatisme cérébral) de capacité à reconnaitre ses propres émotions et/ou celles des autres est dénommé alexithymie. Une difficulté à regarder un interlocuteur et/ou à interpréter les émotions, des visages notamment, est l'un des critères importants de diagnostic du trouble du spectre autistique.

Le cerveau humain peut parfois faire des erreurs d'interprétation. De telles erreurs peuvent provenir de l'interlocuteur, qui peut être un acteur et/ou savoir simuler ou cacher des émotions (il peut par exemple se sentir triste et néanmoins se forcer à afficher un grand sourire, et ainsi parfois tromper son entourage).

Dans de nombreuses cultures, on apprend aux garçons et/ou aux filles à ne pas extérioriser, voire à soigneusement cacher certaines émotions. Le maquillage, le voile, des lunettes noires, peuvent cacher de nombreux signaux émotionnels.

Au XXIe siècle, des concepteurs d'intelligences artificielles cherchent à leur inculquer une capacité à identifier en temps réel les émotions des personnes. Ils le font en imitant plus ou moins le cerveau humain, qui peut détecter de nombreux signaux, pour beaucoup non verbaux et discrets, relatifs aux émotions.

Si dans ces cas présentés plus haut, une méthode automatisée de reconnaissance des émotions obtient des résultats similaires à ceux d'un groupe d'observateurs, elle est généralement considérée comme précise (même si, comme on l'a vu, elle ne mesure pas réellement ce que ressent la personne).

Les alexithymiques (enfants autistes en particulier), n'ont généralement pas une représentation claire de leurs sentiments intérieurs. Et souvent, ils ne disposent pas des mots, chiffres, codes et concepts leur permettant de communiquer leurs émotions aux autres. Dans ces cas, Nursuriati Jamil et al. ont en 2015 suggéré d'analyser la locomotion d'enfants atteints de TSA, comme alternative à l'analyse des émotions du visage ou de la voix, pour au moins détecter des états émotionnels neutres, heureux, tristes ou de colère).

Dans la lignée de l'informatique émotionnelle, une intelligence artificielle peut désormais détecter en temps quasi-réel des indices émotionnels discrets que l'humain ne repère pas.

Comprendre ses émotion peut demander un certain travail, qui peut être accompagné par un psychologue et peut être bientôt par des intelligences artificielles.

Reconnaissance automatique

Des décennies de recherche en psychologie en psychanalyse et psychiatrie, et les progrès récents de la reconnaissance d'image puis de l'intelligence artificielle ont abouti à des méthodes de plus en plus fiables, précises et rapides de reconnaissance automatisée des émotions.

Une littérature abondante porte notamment sur le traitement du signal, l'apprentissage automatique, la vision par ordinateur et le traitement de la parole qui, tous, ont bénéficié des progrès des réseaux bayésiens, de modèle de mélange gaussien et de modèles de Markov cachés et de l'apprentissage profond par les réseaux de neurones artificiels.

Approches

On est passé de systèmes expert dans les années 2010, à des approches algorithmiques unimodales des émotions, puis à des approches fusionnées puis dans les années 2020 à de premières analyses multimodales, bien plus complexes, et bien plus précises, car s'appuyant à la fois sur les textes, la physiologie, l'audio et/ou la vidéo. Différents signaux émotionnels sont alors combinés en intégrant des indications provenant des expressions faciales, des mouvements et gestes du corps, de la parole ou des écrits.

Trois grandes approches co-existent :

- techniques basées sur la connaissance ;

- méthodes statistiques ;

- approches hybrides.

Certains auteurs estiment que ce type de technologie contribue déjà à l'émergence d'un Internet dit « émotionnel ».

Techniques basées sur la connaissance

Parfois aussi appelées techniques « basées sur le lexique », elles utilisent la connaissance du domaine et les caractéristiques sémantiques et syntaxiques du texte et du langage, pour détecter certains types d'émotions.

Pour classer les émotions, elles s'appuient souvent sur des ressources dites « basées sur les connaissances » telles que WordNet, SenticNet, ConceptNet et EmotiNet, pour n'en nommer que quelques-uns. Un avantage de cette approche est l'accessibilité et l'économie induites par la grande disponibilité de ces ressources. Mais une limite de cette technique est son incapacité à gérer les nuances conceptuelles et les règles linguistiques complexes.

- Deux grandes techniques basées sur la connaissance coexistent: les approches basées sur des dictionnaires et celles basées sur des corpus.[réf. nécessaire]

- Les approches basées sur un dictionnaire recherchent des mots-clés relatifs aux émotions (ou aux opinions dans le contexte de l'opinion mining). Les mots recherchés sont tirés d'un dictionnaire de référence ; leurs synonymes et antonymes sont aussi recherchés pour élargir la liste initiale de mots indiquant les émotions.

- En revanche, les approches basées sur un corpus commencent par une liste de départ de mots d'émotion, et élargissent la base de données en trouvant d'autres mots présentant des caractéristiques spécifiques au contexte dans un vaste corpus. Bien que les approches basées sur des corpus prennent en compte le contexte, leurs performances varient toujours selon les domaines puisqu'un mot trouvé dans un domaine peut avoir un autre sens dans un autre domaine.

Méthodes statistiques

Elles utilisent différents algorithmes d'apprentissage automatique supervisé, où un large ensemble de données annotées sont introduites dans les algorithmes pour que le système puisse apprendre et prédire les types d'émotions qu'il rencontrera.

Les algorithmes d'apprentissage automatique fournissent généralement une précision de classification plus intéressante que d'autres approches.

Mais, l'un des défis pour obtenir de bons résultats dans ce processus de classification est qu'il faut disposer d'emblée d'un large ensemble de données de formation.

Certains des algorithmes d'apprentissage automatique les plus utilisés incluent les machines à vecteurs de support, Naive Bayes et Maximum Entropy.

L'apprentissage profond, qui fait partie de la famille non supervisée de l'apprentissage automatique, est aussi très utilisé pour la reconnaissance des émotions,,. Les algorithmes d'apprentissage profond connus incluent différentes architectures de réseaux neuronaux artificiels (ANN) telles que :

- le réseau neuronal convolutif ;

- la mémoire à long terme ;

- l'extreme learning machine.

La popularité de l'apprentissage profond dans ce domaine vient sans doute de son succès dans des applications connexes telles que la vision par ordinateur, la reconnaissance vocale et le traitement du langage naturel (NLP).

Approches hybrides

Elles combinent les avantages des deux technique précédentes (basées sur la connaissance et statistiques), ce qui les rend plutôt plus performantes, mais avec l'inconvénient d'une plus grande complexité informatique.

Certains des travaux qui ont appliqué un ensemble d'éléments linguistiques et de méthodes statistiques axés sur la connaissance incluent l'informatique sentique (sentic computing) et « iFeel », qui ont tous deux intégré la ressource basée sur la connaissance au niveau conceptuel SenticNet,.

Le rôle des ressources basées sur la connaissance dans la mise en œuvre d'approches hybrides est très important dans le processus de classification des émotions.

Ensembles de données

La donnée numérique est au cœur des approches récente de reconnaissance des émotions.

Or il est difficile d'obtenir des données annotées non biaisées et représentatives de toutes les populations, de toutes les cultures, et de toutes les émotions. Or des données de qualité et représentatives sont nécessaires à la formation des algorithmes d'apprentissage automatique.

Pour la tâche de classer différents types d'émotions provenant de sources multimodales sous forme de textes, d'audio, de vidéos ou de signaux physiologiques, les ensembles de données suivants sont disponibles :

- HUMAINE : fournit des clips naturels avec des mots émotionnels et des étiquettes de contexte dans plusieurs modalités

- Base de données de Belfast : fournit des clips avec un large éventail d'émotions provenant de programmes télévisés et d'enregistrements d'interviews

- SEMAINE : fournit des enregistrements audiovisuels entre une personne et un agent virtuel et contient des annotations d'émotions telles que la colère, la joie, la peur, le dégoût, la tristesse, le mépris et l'amusement

- IEMOCAP : fournit des enregistrements de sessions dyadiques entre acteurs et contient des annotations d'émotions telles que le bonheur, la colère, la tristesse, la frustration et l'état neutre

- eNTERFACE : fournit des enregistrements audiovisuels de sujets de sept nationalités et contient des annotations d'émotions telles que le bonheur, la colère, la tristesse, la surprise, le dégoût et la peur

- DEAP : fournit des enregistrements d'électroencéphalographie (EEG), d'électrocardiographie (ECG) et de vidéos faciales, ainsi que des annotations d'émotions en termes de valence, d'éveil et de dominance des personnes regardant des extraits de films

- DREAMER : fournit des enregistrements d'électroencéphalographie (EEG) et d'électrocardiographie (ECG), ainsi que des annotations d'émotions en termes de valence, de dominance des personnes regardant des extraits de films

- MELD : est un ensemble de données conversationnelles multipartites où chaque énoncé est étiqueté avec émotion et sentiment. MELD propose des conversations au format vidéo et convient donc à la reconnaissance multimodale des émotions et à l'analyse des sentiments. MELD est utile pour l'analyse multimodale des sentiments et la reconnaissance des émotions, les systèmes de dialogue et la reconnaissance des émotions dans les conversations.

- MuSe : propose des enregistrements audiovisuels d'interactions naturelles entre une personne et un objet. Il contient des annotations d'émotions discrètes et continues en termes de valence, d'excitation et de fiabilité, ainsi que des sujets de discours utiles pour l'analyse multimodale des sentiments et la reconnaissance des émotions.

- UIT-VSMEC : est un corpus d'émotions sur les réseaux sociaux vietnamiens standard (UIT-VSMEC) avec environ 6 927 phrases annotées par des humains avec six étiquettes d'émotion, contribuant à la recherche sur la reconnaissance des émotions en vietnamien, une langue à faibles ressources en traitement du langage naturel (NLP).

- BED : apporte de la valence et de l'excitation aux personnes qui regardent des images. Il comprend également des enregistrements d'électroencéphalographie (EEG) de personnes exposées à divers stimuli (SSVEP, repos les yeux fermés, repos les yeux ouverts, tâches cognitives) pour la tâche de biométrie basée sur l'EEG.

Applications

La reconnaissance des émotions intéresse divers secteurs, pour des raisons différentes.

À titre d'exemple, Affectiva, issue du MIT, fournit un logiciel d'intelligence artificielle qui rend plus efficace l'exécution de tâches auparavant effectuées manuellement par des personnes. Il aide au recueil d'informations pertinentes sur les expressions faciales et vocales, dans des contextes spécifiques où les téléspectateurs ont consenti à partager ces informations. Ici, au lieu de répondre à une longue enquête sur ce qu'il ressent par exemple en regardant une vidéo éducative ou une publicité, le spectateur peut consentir à ce qu'une caméra filme votre visage et écoute ses réactions. Des observateurs notent quand, au cours de l'expérience, ce spectateur montre des expressions telles que l'ennui, l'intérêt, la confusion ou le sourire. (il ne s'agit pas ici de lire les sentiments les plus intimes, mais uniquement ce que le visage et la voix expriment extérieurement).

Affectiva permet aussi à des enfants autistes et à des personnes aveugles de se faire « traduire » les expressions faciales. Affectiva peut aussi aider des robots à interagir plus « intelligemment » avec les humains, ou et surveiller les signes d'attention d'un conducteur durant la conduite d'un véhicule, dans le but d'améliorer la sécurité routière et celle du conducteur.

La recherche universitaire l'utilise de plus en plus pour certaines questions de sciences sociales liées aux sentiments, aux élections, aux manifestations et à la démocratie. Certaines études se concentrent sur les expressions faciales des candidats politiques sur les réseaux sociaux, révélant par exemple le caractère extraverti des politiciens, qui expriment facilement leur bonheur,,.

Les chercheurs étudient les manifestations, guerres, ou contextes de violence, etc., où l'on s'attend à des affects plus complexes et parfois négatifs tels que la colère, la douleur, la dépression, la tristesse, la frustration, l'empathie, etc., ont du développer leurs propres modèles pour mieux distinguer ces émotions.

La recherche montre aussi qu'en 2020, les outils de vision par ordinateur tels qu'Amazon Rekognition ne sont précis que pour détecter le bonheur (« détecteurs de bonheur »).

Un brevet déposé par Snapchat en 2015 porte sur un moyen d'extraire des données à partir d'images de foules, lors d'événements publics, en effectuant une reconnaissance algorithmique des émotions sur les selfies géolocalisés des utilisateurs.

« Emotient » était une startup dédiée à la reconnaissance des émotions par une intelligence artificielle analysant les combinaisons de froncements de sourcils, de sourires et d'autres expressions des visages, pour prédire « les attitudes et les actions basées sur les expressions faciales ». Apple a acheté Emotient en 2016 et utilise la technologie de reconnaissance des émotions pour améliorer l'intelligence émotionnelle de ses produits.

nViso fournit un outil de reconnaissance des émotions en temps réel, pour les applications Web et mobiles, via une API en temps réel.Visage Technologies AB propose une estimation des émotions dans le cadre de son SDK Visage à des fins marketing et scientifiques et à des fins similaires.

Eyeris travaille pour des fabricants de systèmes embarqués, dont des constructeurs automobiles et des entreprises de robotique sociale, pour intégrer ses logiciels d'analyse faciale et de reconnaissance des émotions ; ainsi qu'avec les créateurs de contenu vidéo pour les aider à mesurer l'efficacité perçue de leur création vidéo courte et longue,.

De nombreux systèmes agrègent des indices d'émotions communiquées en ligne (à partir des « J'aime » de Facebook par exemple, et via le nombre d'expressions classées positives et/ou négatives dans le textes et messages.

La reconnaissance des affects est aussi utilisée dans certains jeux et systèmes de réalité virtuelle, parfois à des fins éducatives, ou pour donner aux joueurs ou à des influenceurs un contrôle plus naturel sur leurs avatars sociaux.

Prospective

La reconnaissance automatique des émotions va probablement être de plus en plus précise avec les intelligences artificielles multimodales explorant plusieurs modalités (texte (conversation), audio (mots, expressions, ton et modulations de la voix, photo/vidéo et même physiologie pour détecter les émotions.

En 2024, deux chercheurs coréens (université Yonsei à Séoul) ont proposé un nouveau modèle d'intelligence artificielle de reconnaissance des émotions. Selon eux, en fusionnant des données physiologiques, mais aussi environnementales et personnelles, il se montre plus fiable.

Il a été proposé de faire détecter par une intelligence artificielle les émotions de soldats lors d'entraînements en environnements simulés pour évaluer leur aptitude à supporter les conditions de combat. Une telle intelligence artificielle pourrait aussi être « utilisée pour évaluer les conditions mentales dans les situations de combat ».

Ces avancées techniques pourraient grandement rapprocher les machines et certains robots de l'intelligence émotionnelle humaine en leur permettant de percevoir, maîtriser, exprimer et décoder l'émotion chez autrui. Mais l'intelligence artificielle semble par contre encore loin de deux autres composantes majeures de l'intelligence émotionnelle :

- la conscience de soi qui inclut la capacité à ressentir ses propres émotions, ce qui permet dans une certaine mesure de les autoréguler ;

- la capacité d'empathie qui repose notamment sur le système des neurones miroir.

Ces évolutions techniques posent des questions éthiques et philosophiques importantes, notamment quant à la protection de la vie privée ou à l'existence d'éventuels biais de la part des intelligences artificielles.

Reconnaissance des émotions dans les textes et conversations

La donnée textuelle (compte rendus d'auto-évaluations, de tests, réponses à un questionnaire ; transcriptions de monologues, dialogues ou conversations, journal intime, etc.) est un objet numérique favorable à la reconnaissance automatique des émotions, souvent massivement et gratuitement disponibles dans l'environnement numérique.

Comparativement à d'autres sortes de données, elle est plus légère et facile à compresser (grâce aux répétitions fréquentes de mots et de caractères dans les langues).

Les émotions peuvent en être extraites via l'analyse de « mots/phrases » indicateurs de divers registres émotionnels,.

Le domaine de la reconnaissance automatique des émotions transmises par la parole (SER pour speech emotion recognition) est en plein développement.

Reconnaissance des émotions dans les médias audio

Différent de la reconnaissance des émotions dans le texte, les signaux vocaux sont utilisés pour la reconnaissance afin d'extraire les émotions de l'audio.

Reconnaissance des émotions dans les médias vidéo

La donnée vidéo combine des données audio, des images successives et parfois du texte (sous-titres).

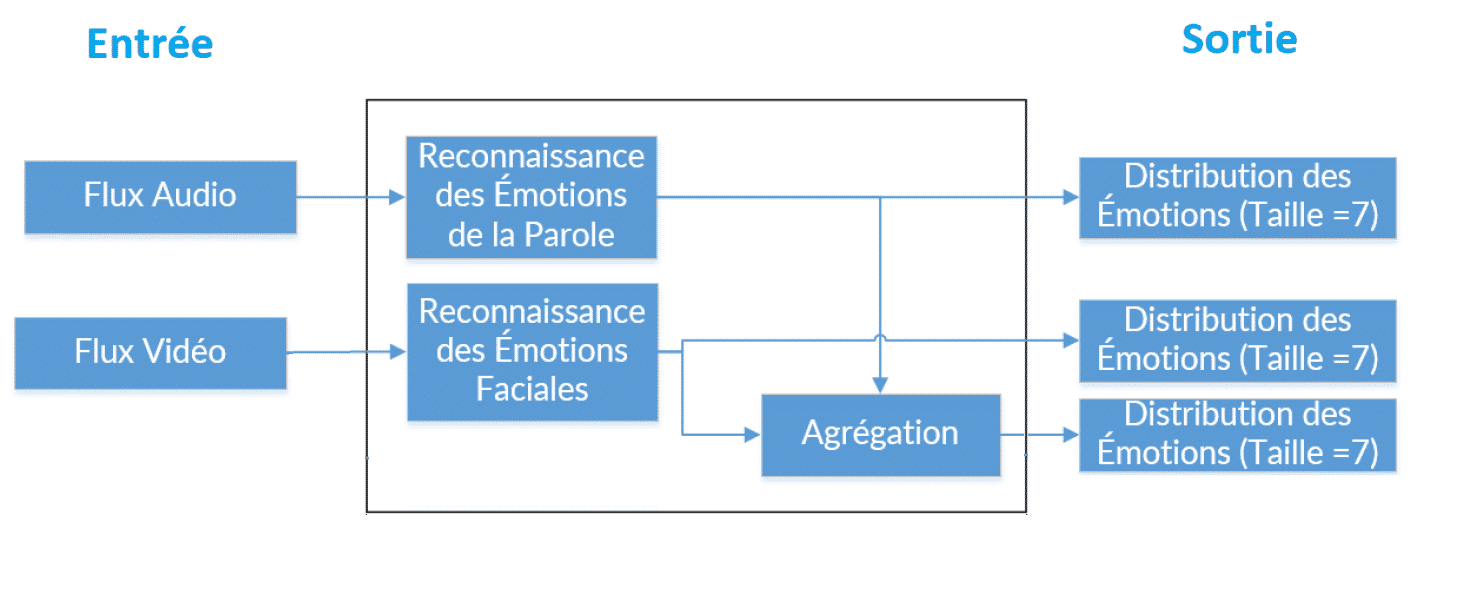

Reconnaissance des émotions en quasi-temps réel dans la conversation

La reconnaissance des émotions dans la conversation (REC) extrait les émotions (voire les opinions dans le cas de l'opinion mining) exprimées par les participants, à partir de données conversationnelles, y compris massivement récoltées sur des plateformes sociales, telles que Facebook, Twitter/X, YouTube et autres. La REC peut se baser sur des données d'entrée telles que du texte, de l'audio, de la vidéo ensuite agrégées ou sur une combinaison de ces données, ou comme avec GPT-4o (depuis mai 2024) en étant nativement capable de détecter émotions telles que la peur, la douleur, l'intérêt, le doute, le plaisir, etc. à partir d'un même réseau de neurone, omni-modal.

Références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « Emotion recognition » (voir la liste des auteurs).

Voir aussi

Bibliographie

- (en) Naveed Ahmed, Zaher Al Aghbari et Shini Girija, « A systematic survey on multimodal emotion recognition using learning algorithms », Intelligent Systems with Applications, vol. 17, , article no 200171 (e-ISSN 2667-3053, OCLC 9763136221, DOI 10.1016/j.iswa.2022.200171).

- (en) Didar Dadebayev, Wei Wei Goh et Ee Xion Tan, « EEG-based emotion recognition: Review of commercial EEG devices and machine learning techniques », Journal of King Saud University - Computer and Information Sciences, vol. 34, no 7, , p. 4385-4401 (ISSN 1319-1578, e-ISSN 2213-1248, DOI j.jksuci.2021.03.009).

- (en) ShiHao Zou, Xianying Huang, XuDong Shen et Hankai Liu, « Improving multimodal fusion with Main Modal Transformer for emotion recognition in conversation », Knowledge-Based Systems, vol. 258, , article no 109978 (ISSN 0950-7051, e-ISSN 1872-7409, OCLC 9682162458, DOI 10.1016/j.knosys.2022.109978, lire en ligne [PDF]).

Articles connexes

- Informatique affective

- Perception du visage

- Système de reconnaissance faciale

- Analyse des opinions

- Exactitude interpersonnelle

- Portail de l’informatique